الذكاء الاصطناعي يتسلّل إلى الدوريات الأكاديمية… والتدقيق يصبح أكثر صعوبة

الذكاء الاصطناعي يتسلّل إلى الدوريات الأكاديمية… والتدقيق يصبح أكثر صعوبة

كتب ا د وائل بدوى

لم يعد النقاش حول الذكاء الاصطناعي مقتصرًا على قاعات الجامعات أو مراكز الأبحاث، بل أصبح في قلب أزمة جديدة تمسّ النشر الأكاديمي وموثوقيته. خلال الأشهر الأخيرة، تكشفت عدة وقائع عن بحوث منشورة في مجلات علمية مرموقة احتوت على عبارات أو صيغ تكشف بوضوح أن الذكاء الاصطناعي التوليدي كان حاضرًا في كتابتها، لكن دون أن يصرّح المؤلفون بذلك.

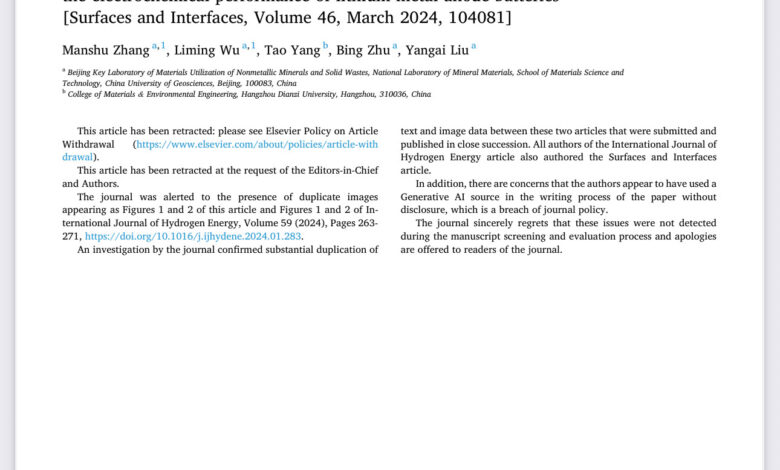

في إحدى الدراسات المنشورة بمجلة Resources Policy – الصادرة عن دار النشر Elsevier – فوجئ القراء بوجود عبارة غريبة وسط نص علمي تقول: “يرجى ملاحظة أنني كنموذج لغوي للذكاء الاصطناعي غير قادر على إنشاء جداول أو إجراء اختبارات”. هذه الصياغة المألوفة لمستخدمي برامج مثل ChatGPT دفعت ناشرين وخبراء إلى التساؤل: هل نحن أمام استخدام غير مُعلن للذكاء الاصطناعي في بحوث محكّمة؟

سياسات متباينة ورقابة محدودة

اللافت أن معظم دور النشر الكبرى لا تمنع استخدام أدوات الذكاء الاصطناعي بشكل مطلق، لكنها تشترط الإفصاح الصريح عن هذا الاستخدام. مجلات مثل Nature و JAMA وضعت لوائح واضحة تلزم الباحثين بالتصريح إذا استعانوا بالذكاء الاصطناعي في التحرير أو الصياغة. بينما تمنع دوريات أخرى إدراج النصوص أو الصور المنتجة آليًا دون إذن مسبق من المحررين.

لكن المشكلة الأعمق أن أدوات كشف النصوص المنتَجة بالذكاء الاصطناعي ليست دقيقة بعد، بخلاف أدوات كشف الانتحال أو السرقة الأدبية. هذا يعني أن المجلات تعتمد في كثير من الأحيان على الصدفة، أو على يقظة المراجعين، لاكتشاف مثل هذه المخالفات.

بين الفائدة والمخاطر

لا يمكن إنكار أن الذكاء الاصطناعي قد يساعد كثيرًا الباحثين، خاصة غير الناطقين بالإنجليزية، في تحسين لغة أوراقهم العلمية وزيادة فرص قبولها. لكن في المقابل، ثمة مخاطر جدية:

- إمكانية إدخال مراجع وهمية أو بيانات غير صحيحة.

- احتمال تمرير محتوى متحيّز أو غير دقيق مأخوذ من الإنترنت.

- تعريض ثقة القارئ في النشر الأكاديمي للاهتزاز، إذا شاع استخدام الذكاء الاصطناعي دون رقابة.

هذه المخاطر تجعل الاستخدام غير المعلن بمثابة شكل جديد من الانتحال، لأنه ينسب إنتاج الآلة إلى الباحث وكأنه من تأليفه.

لعبة القط والفأر

خبراء أخلاقيات البحث العلمي شبّهوا هذه الظاهرة بـ”لعبة القط والفأر”. فكلما طوّرت المجلات أدوات للكشف، ظهر جيل أحدث من النماذج اللغوية أكثر قدرة على محاكاة البشر. بعض الدراسات الأكاديمية كشفت أن محتوى ChatGPT يمكن تمييزه بنسبة تصل إلى 99% في نصوص محددة، لكنه يظل أقل تعقيدًا وأكثر عمومية من كتابة الإنسان. ومع ذلك، هذه الفوارق قد تتلاشى مع تطور التقنية، ما يضاعف صعوبة الضبط.

الورطة الأخلاقية ودور الناشرين

الأزمة لا تخصّ الباحثين وحدهم. فدور النشر الأكاديمية تقف اليوم أمام مسؤولية مضاعفة: كيف تضمن نزاهة ما يُنشر تحت اسمها؟ وكيف تحافظ على سمعة المجلات التي بنت مصداقيتها على مدى عقود؟

الحقيقة أن دور النشر تتحمل مسؤولية أكبر من الباحثين أنفسهم؛ فالأوراق البحثية تمر عادةً عبر سلسلة طويلة من الفلاتر: مراجعة أولية من المحرر، ثم تقييم علمي من ثلاثة مراجعين متخصصين على الأقل، وغالبًا تُعاد الورقة بعد طلب تعديلات جوهرية، ليتم تقييمها مرة أخرى من قِبل مراجعين جدد. هذا بجانب التدقيق اللغوي وإعادة الصياغة لتوحيد قالب النشر.

فكيف، إذن، تمر عبارات صريحة تكشف عن استخدام الذكاء الاصطناعي عبر كل هذه المراحل دون أن يلتقطها أحد؟ وهل يعني ذلك أن المراجعة أصبحت شكلية أكثر منها جوهرية؟

هنا يبرز التساؤل الجوهري:

هل يكفي أن تضع دور النشر سياسات معلنة، أم أن عليها تطوير آليات تدقيق ومراجعة أكثر صرامة قبل نشر أي ورقة؟

فالقضية لم تعد مجرد خطأ فردي، بل تهديدًا للبنية المعرفية ذاتها. فإذا فقد القارئ ثقته في جودة ومصداقية الأوراق العلمية، فإن ذلك قد يفتح الباب أمام انتشار الأوراق الزائفة وتضخم “أدبيات علمية” مشبوهة، وهو ما سيضر بمكانة البحث العلمي عالميًا.

الذكاء الاصطناعي بات واقعًا لا يمكن تجاهله في عالم النشر الأكاديمي. قد يكون أداة فعالة لتحسين الكتابة وزيادة الإنتاج العلمي، لكنه في الوقت نفسه ممر خطير للانتحال وفقدان الثقة إذا لم يتم ضبطه بصرامة. الحل يكمن في الموازنة بين الاستفادة من الإمكانات التقنية وبين صيانة أخلاقيات البحث.

ويبقى السؤال معلقًا:

هل تتحمل دور النشر مسؤوليتها الكاملة في التدقيق قبل النشر، أم ستبقى تلقي بالعبء كله على الباحثين والمراجعين؟ وهل تكفي سياسات الإفصاح وحدها، أم أن دور النشر مطالَبة بمراجعة أعمق وأكثر جدية، خاصة أنها تمتلك منظومة معقدة من التحكيم والتدقيق قبل النشر؟